Todavía me acuerdo de ese primer momento en que le conté a mi mamá que iba a estudiar física. Ella mantuvo la mirada fija en la pantalla de su computadora y, muy tranquilamente, me dijo:

“¿Física? Pero ¿no te vas a morir de hambre con eso?”

Por suerte yo ignoraba completamente el estado de la ciencia en el país y pensaba que esas sólo eran ocurrencias de mi madre, que todo iba a estar bien y que estudiar ciencia era sinónimo de fama, dinero, prestigio y rocanrol (?). Así que me anoté nomás.

Por el contrario, muchas veces sucede que se rebaja a la ciencia, se pone en duda su utilidad, se la ve como un lujo que sólo deberían darse esos países que admiramos y a los que quisiéramos parecernos más. Irónicamente, no nos preguntamos si no es precisamente la inversión en investigación y desarrollo lo que hizo que esos países se convirtieran en lo que son.

Este es un intento de abrir esa pregunta y compartir una arista de la ciencia que quizá no sea tan maravillosa, ni cautivadora, ni romántica. Es momento de sentarnos a hablar de una ciencia rentable.

Lluvia de inversiones.

Esta historia empieza en 1900. Entre otras cosas interesantes que seguro pasaron ese año, el alemán Max Planck publicaba un artículo explicando algo que la física de la época no terminaba de entender: cómo calcular la energía de radiación de un cuerpo negro (un objeto que absorbe toda la radiación que recibe). Detrás de este conjunto de palabras difíciles se encuentra un fenómeno relativamente sencillo: los cuerpos emiten radiación a distintas energías, como por ejemplo el Sol que emite (entre otras) luz visible, ondas infrarrojas (de menor energía) y ondas ultravioletas (de mayor energía, y por eso potencialmente dañinas para el cuerpo humano). Entender cómo hacer el cálculo de la energía total emitida por el Sol, por ejemplo, iba a impactar en el mundo de maneras impensadas durante el siglo siguiente.

Planck llegó para echar un poco de luz al asunto. Antes que nada, se comportó como el buen físico que era y se basó en observaciones generadas por los mejores experimentos de la época, con los que logró escribir una ecuación matemática que se ajustaba correctamente a esos resultados. Con ella en mano, quiso obtener esa misma ecuación pero esta vez basándose en principios físicos más fundamentales, y para lograr eso tuvo que atravesar al menos dos obstáculos importantes. El primero fue él mismo: tuvo que aceptar teorías físicas con las que no estaba de acuerdo, en particular la idea del físico vienés Ludwig Boltzmann de que ciertos fenómenos se podían explicar como el resultado colectivo de muchas interacciones más pequeñas. Es decir, implicaba aceptar la suposición de que la materia está compuesta por átomos que interactúan entre sí, una idea que en ese momento distaba de tener el consenso de la comunidad científica. El segundo obstáculo fue que además se le tuvo que ocurrir una idea con la que orinaba aún más afuera del tarro, pero que parecía funcionar muy bien. Planck propuso que, al igual que la materia, la energía únicamente se puede transportar en porciones discretas e indivisibles, en pequeños paquetes que él llamó ‘cuantos de energía’.

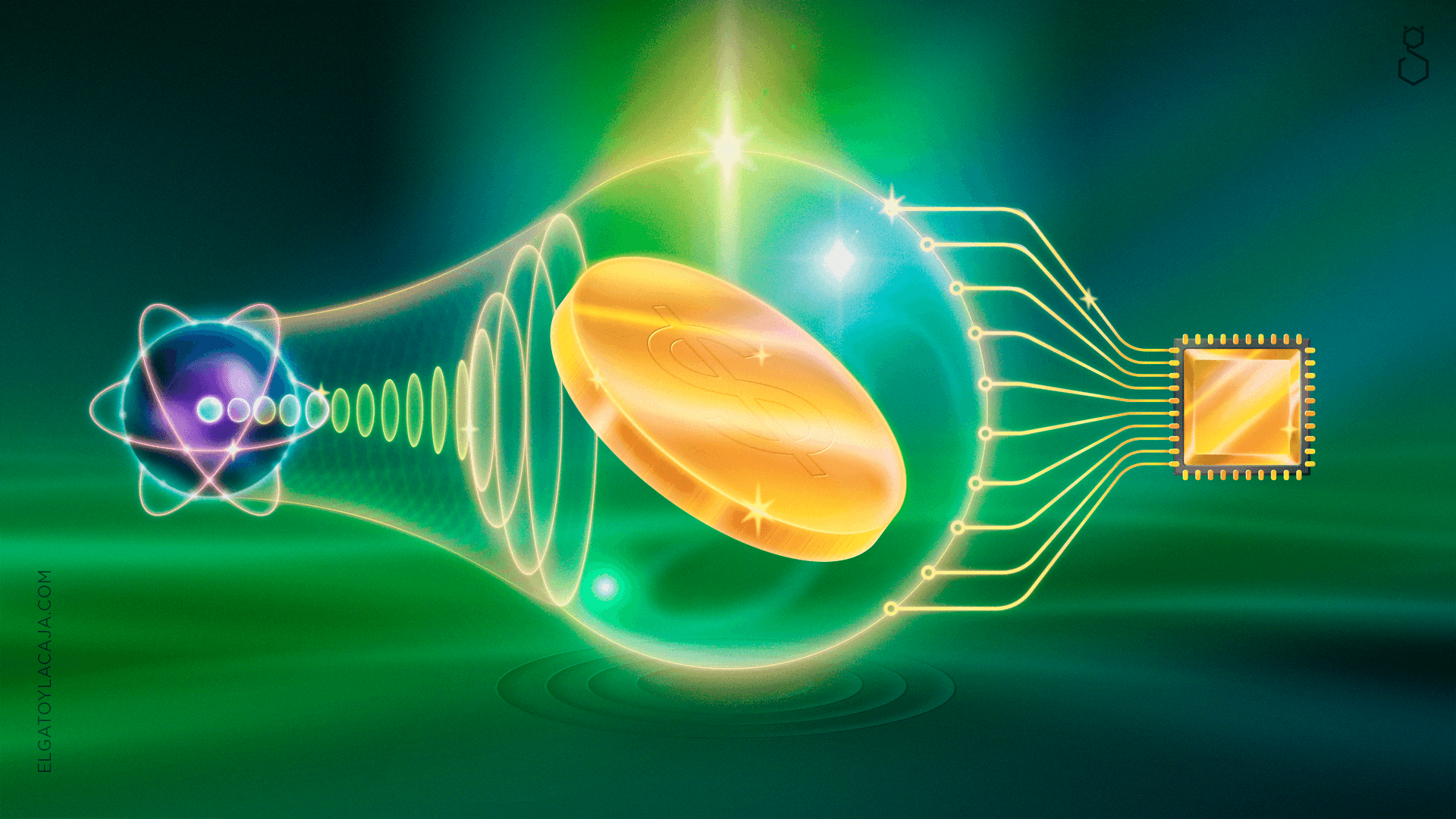

Pero más cosas pasaron cuando se empezaron a entender las implicancias de esta proposición. Apenas cinco años después del artículo de Planck, un Einstein aún sin canas usaba esa idea para explicar otra cosa que antes tampoco había podido ser desgranada: el hecho de que, al iluminar un material conductor, este absorbe parte de esa luz, estimulando los electrones en su interior y generando electricidad dentro del material. Esto es el efecto fotoeléctrico, que transforma luz en electricidad y permite así los sensores de luz que sirven, por ejemplo, para avisarle a Whatsapp que estás escuchando el audio con el celular apoyado en el oído. Lo revolucionario, sin embargo, era que esto implicaba entender finalmente que la luz también está compuesta por partículas (esos ‘paquetes indivisibles’ de energía, luego llamados ‘fotones’), pero no por eso deja de comportarse también como una onda, un fenómeno al que se llamó la dualidad onda-partícula.

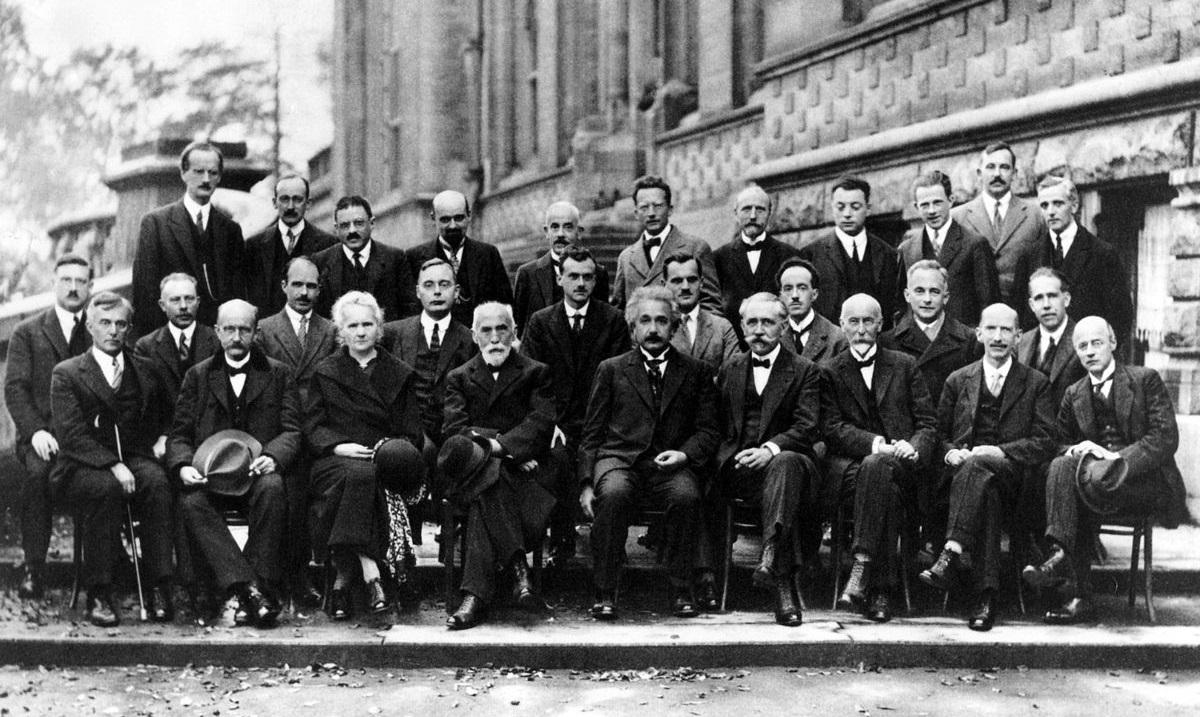

La consecuencia de esto fue una cantidad desmedida de experimentos, propuestas e ideas que más tarde permitieron formar (discusiones acaloradas mediante) una teoría consistente ―la mecánica cuántica― que explica el comportamiento de la materia microscópica y, de yapa, buena parte de la química, los sólidos, e infinidad de otros fenómenos. Un punto crucial de estos debates se dio en una de las reuniones científicas más importantes de la época: la quinta conferencia de Solvay en 1927, que dejó interpretaciones ganadoras y perdedoras de la teoría cuántica (y a varios científicos peleados). Acá se pueden ver las caras largas ocasionadas.

Conferencia de Solvay, 1927. Abajo, tercera desde la izquierda, una Marie Curie perdida entre un mar de muchachos nos recuerda que, si ha habido algo más difícil que escalar en el sistema científico, ha sido hacerlo siendo mujer.

En los años ‘40 la cuántica ya se usaba para tratar de explicar todo. Entre otros casos de éxito se empleó para estudiar los materiales sólidos, lo cual dio lugar a la física del estado sólido, que a su vez hoy es la base de la física de materiales. Sobre esos hombros, en 1947 un grupo de físicos, entre ellos los ganadores del Nobel John Bardeen, Walter Brattain y William Shockley, desarrollaron una teoría y experimentos que resultaron en un nuevo descubrimiento con potenciales aplicaciones prácticas. Se trataba de un dispositivo sólido pequeño con tres patas metálicas, diseñado para cumplir funciones varias en un circuito electrónico. Habían inventado el transistor.

El transistor es un componente versátil de un circuito electrónico, puede funcionar como amplificador de una señal, y también como conmutador (es decir, como una llave interruptora que puede estar en uno de dos estados, los famosos ‘ceros y unos’ de las computadoras). Esto permitió manipular y controlar los estados de un sistema electrónico con circuitos fiables, baratos y de tamaño reducido, al contrario de los dispositivos que se usaban antes (las válvulas de vacío), que eran objetos más caros, más grandes y poco fiables, ya que debido a su fragilidad se rompían seguido. Usando transistores se podían realizar circuitos muy pequeños que reprodujeran las reglas de la lógica básica, llamados comúnmente compuertas lógicas, y que abrieron la puerta a la posibilidad de poder manipular operaciones lógicas cada vez más complejas. Hola, computadoras modernas.

El transistor tuvo que esperar décadas de desarrollo de teoría cuántica para que un grupo de personas altamente especializadas en el tema dieran un paso fuera del límite de lo conocido. Para 1954 la revolucionaria radio de transistores ya era una realidad, un invento que consistía en un dispositivo relativamente pequeño y transportable que permitía, entre otras cosas, ir a escuchar música al parque o molestar a los otros pasajeros del colectivo.

A la izquierda, el semiconductor que revolucionó la electrónica. A la derecha, Transistor, la mascota oficial del Instituto Balseiro.

Llegaron los ‘60 y esta tecnología empezó a colmar las industrias. Un grupo de jóvenes (hoy conocidos como ‘los niños de Fairchild’) con recientes doctorados en física e ingeniería se mudó a la Bahía de San Francisco (California) para trabajar para William Shockley desarrollando transistores comerciales. Por problemas de dirección y desacuerdos varios, los ocho científicos renunciaron para fundar Fairchild Semiconductor. Su renuncia simultánea fue algo increíble para la cultura de la época, en la que se esperaba que un trabajo fuera para toda la vida. Por esto es que incluso hasta hoy en inglés se los conoce como ‘los ocho traidores’.

Los niños de Fairchild, 1957. Entre ellos Bob Noyce, el del medio adelante, y Gordon Moore, primero a la izquierda –Moore el de la Ley de Moore, una fórmula que predice el crecimiento exponencial de la evolución de las computadoras que todavía funciona al día de hoy.

Estos nuevos emprendedores, bajo la dirección de Robert Noyce (Bob, para los amigos), desarrollaron y mejoraron enormemente un novedoso producto que iba a revolucionar la tecnología una vez más. Era un chip de silicio compuesto por varios transistores planos interconectados, un módulo independiente preparado para realizar tareas predeterminadas: el circuito integrado. Para ese entonces ya empezaba a quedar claro que las aplicaciones de esta tecnología eran virtualmente infinitas, por lo que empleados de Fairchild empezaron a renunciar para crear cientos de empresas derivadas (spin-offs) conocidas como las Fairchildren, entre las que se pueden encontrar, por ejemplo, a AMD e Intel. Fue en esta última, fundada por Bob Noyce y Gordon Moore, donde se dio el siguiente paso conceptual con el invento de otro tipo de chip o circuito integrado, uno que entre varias ventajas de diseño tenía la capacidad de que sus funciones sean programables por el usuario mediante un lenguaje de programación de bajo nivel, también llamado lenguaje de máquina. Se trata del microprocesador, el cerebro de las computadoras y celulares de hoy en día.

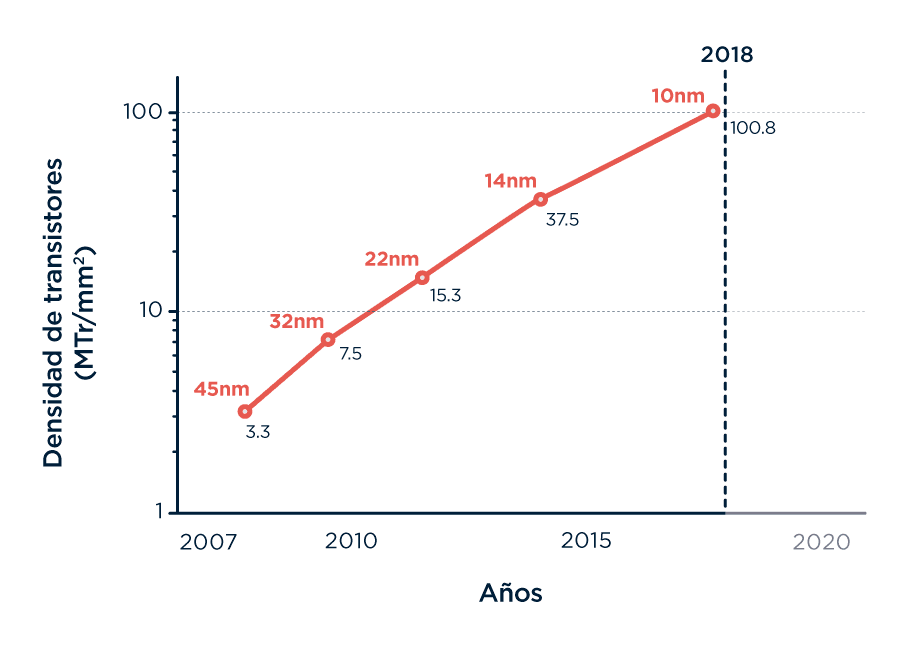

Fue entonces que la Bahía de San Francisco, más conocida como Silicon Valley, empezó a ganar reputación por esa cultura emprendedora que se estaba gestando y que aún sigue vigente, llena de emprendedores en tecnología, y junto con ellos el surgimiento de los inversores de capitales de riesgo: gente con plata, amor al riesgo, y grandes expectativas. Silicon Valley no debe su nombre a una avalancha de aplicaciones dudosas para celulares, sino al desarrollo de estos dispositivos planos basados en silicio con una gran cantidad de transistores agrupados en un espacio reducido, que hoy llegan a ser cien millones por milímetro cuadrado.

Densidad de transistores (medida en millones de transistores por milímetro cuadrado) en chips de Intel. En naranja las denominaciones para los chips que corresponden a esos transistores. Tal como propone la ley de Moore, el crecimiento es exponencial.

El resto es historia conocida. Computadoras, software, Internet, todo cada vez más compacto y portable, más ubicuo, central e indispensable para las revoluciones tecnológicas que les siguieron y los mercados enteros que crearon. Todo posible por haber descubierto cómo operan los electrones en escalas atómicas y luego aprender a manipularlos para que hagan lo que imaginemos. Un conjunto de gente curiosa e interesada en cómo funciona el Universo, generando teorías sobre moléculas, átomos y partículas; gente que en las primeras épocas no tenían más que un interés puramente académico, dio lugar 100 años más tarde a una revolución tecnológica, informática y de comunicaciones sin precedentes. Fueron todos estos elementos, así como los profesionales, las comunidades que tejieron, y las instituciones públicas y privadas que les dieron espacio y apoyo, los que hicieron posible transitar este camino.

Hace apenas dos años, el Secretario General de las Naciones Unidas Ban Ki-moon decía que cerrar la brecha entre países desarrollados y en desarrollo dependía primero de cerrar la brecha de inversión en ciencia, tecnología e innovación (CTI): “Mientras que un objetivo de un 1% del PBI para investigación y desarrollo es percibido como alto para muchos gobiernos, los países con sistemas fuertes y efectivos de CTI invierten hasta el 3,5% de su PBI en eso. (…) Si los países quieren romper el ciclo de pobreza (…) tendrán que definir metas ambiciosas de inversión para CTI, incluyendo asignaciones especiales para la promoción de ciencia básica, y para la educación y alfabetización científica”.

El último informe de Unesco sobre inversión en Ciencia y Técnica muestra una Corea del Sur que pica en punta con una inversión del 4,3% de su PBI, Israel con 4,2% y Japón con 3,4%. Para encontrar Argentina tenemos que ir a buscarla bien abajo, al 0,6% del PBI. Ahí donde las cosas no traccionan, donde las revoluciones científicas, tecnológicas y económicas no suceden; ahí donde la palabra de los expertos en políticas públicas no se escucha y los patrones se repiten sin desafiarse.

“¿No te vas a morir de hambre con eso?”, me dijo. La mirada fija en la pantalla de su computadora. Y…