“Pedí una nueva remesa y preparé la mezcla. La ebullición tuvo lugar y también el primer cambio de color, pero no el segundo. La bebí y no causó efecto. He buscado esas sales por todo Londres. Ha sido en vano. Al fin he llegado al convencimiento de que esa primera remesa era impura y que fue precisamente esa impureza desconocida lo que dio eficacia a la poción.”

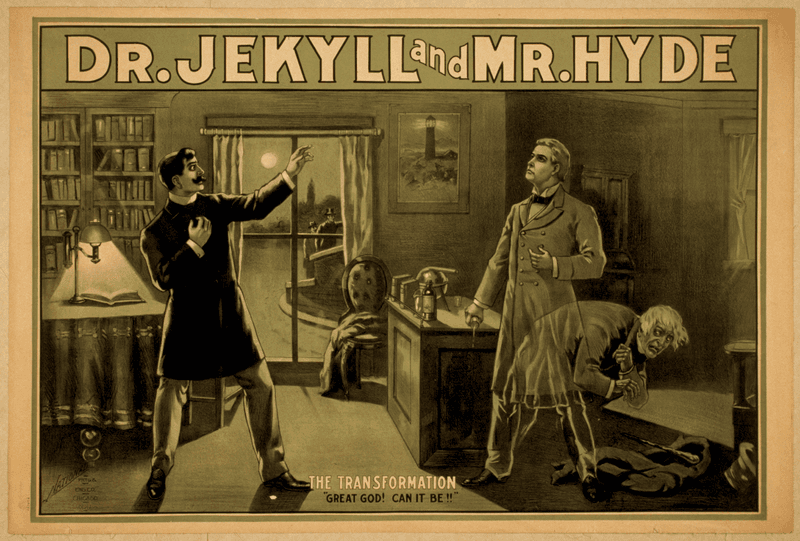

El extraño caso del Dr. Jekyll & Mr. Hyde – Robert Louis Stevenson

El extraño caso del Dr. Jekyll y Mr. Hyde vio la luz en el año 1886 y rápidamente se convirtió en un clásico al punto tal que, como ocurre con la mayoría de los clásicos, no hace falta haberlo leído para conocer la historia: un reputado científico descubre una pócima que lo convierte en un sujeto perverso y violento, disociando su personalidad y cambiando su aspecto físico. Entre ambas personalidades, se libra una trágica batalla que supo tener muchas reversiones en la literatura y el cine. En las últimas páginas (Spoiler Alert), el Dr. Jekyll, con nuevos ingredientes, quiere repetir su exitosa fórmula. Pero no lo logra, pues el efecto de la poción se debía a una impureza en los viejos insumos, ya consumidos. Esta impureza es imposible de rastrear, lo que naturalmente le impide al Dr. Jekyll volver a obtener el mismo resultado. Quién hubiera dicho que en esta metáfora fascinante del trastorno psiquiátrico de personalidades múltiples, en este planteo filosófico acerca de la dualidad humana, su autor Robert Louis Stevenson también iba a introducir un concepto fundamental de la ciencia: la reproducibilidad en los experimentos científicos.

Otro ladrillo en la pared

El conocimiento –entendido como un bien colectivo y colaborativo– se construye igual que una pared: con ladrillos. Cada nuevo descubrimiento es un ladrillo, sobre el cual se colocan otros, sobre los cuales se colocan otros. Para que la pared no se venga abajo, es importante que esos descubrimientos sean sólidos. Quienes lean esos datos los tomarán como fehacientes y como punto de partida desde el cual obtener nuevos datos. Si esto no fuera así, en todos los laboratorios del mundo se estaría constantemente reinventando la rueda. Para asegurarse al interior del laboratorio de que los resultados son confiables, una regla (entre muchas) básica y bastante intuitiva es que se debe hacer el mismo experimento varias veces, y todas las veces −o la gran mayoría− el resultado debe ser similar. Así, el investigador puede asumir, con un alto grado de confianza, que el fenómeno descubierto no se debe a una casualidad, o a que ese día justo llovía, o a que justo cayó sobre el tubo de ensayo con azúcar, flores y muchos colores una gota de la sustancia X y sin querer se crearon las tres heroínas feministas preferidas de las niñas de los ‘90. El grado de ‘similitud’ entre estos resultados nunca va a ser del 100%, pero con herramientas estadísticas podemos estimarlo, ponerle un límite y quedarnos tranquilos de que los experimentos están funcionando.

Pero, para todo el resto de la comunidad científica que no presencia los experimentos, ¿cómo puede comunicarse que los resultados obtenidos son reales y que su interpretación es correcta? Para que todo el sistema de comunicación de la ciencia funcione, se inventó el denominado peer review (revisión por pares). Este consiste, básicamente, en proponer un descubrimiento en forma de artículo escrito, con un formato predeterminado, detallando por qué, cómo y con qué objetivo se realizaron los experimentos, mostrando e interpretando los resultados. Esta propuesta, llamada manuscrito, se envía a una revista que tiene un plantel de científicos (los ‘pares’) expertos en el o los temas relacionados con el artículo, que lo leen y critican. De acuerdo a la calidad de los resultados y del manuscrito, los revisores pueden aceptarlo, o pueden decidir que el manuscrito no alcanza los estándares de la revista, en cuyo caso no es publicado, e incluso pueden sugerir nuevos abordajes o que se hagan más experimentos que aporten robustez a los hallazgos. Gracias a esta corrección de los expertos, los manuscritos se ponen a prueba, los datos se vuelven confiables y los científicos, reconocidos.

Como a los humanos nos encanta medirnos, rápidamente se construyeron ‘rankings’ de las mejores y peores revistas en base a cuán expertos son los científicos que las revisan, cuán importantes son los descubrimientos que en ellas se publican y cuánta gente las lee y las cita. Así, los ‘gigantes’ son las revistas de las que más o menos todos hemos escuchado hablar: Nature, Science, Cell; mientras que revistas más pequeñas o más especializadas son un poco (o bastante) menos conocidas. Hoy en día, además, cuando un investigador concursa para un subsidio, o una beca, o un espacio en un instituto, o un cargo en una universidad, normalmente uno de los primeros puntos que se evalúan de su currículum es cuántos artículos publicó y en qué posición del ranking están las revistas en las que lo hizo.

En el este está el agite

En el año 2013, dos laboratorios de Estados Unidos, uno en California (costa oeste) y otro en Massachusetts (este del país), trabajaron colaborativamente en un proyecto sobre el cáncer de mama. En primera instancia, obtuvieron células de mamas sanas y procedieron a estudiarlas con dos abordajes distintos: en uno de los laboratorios iban a romper las células para ver qué había adentro mientras que en el otro laboratorio las necesitaban enteras para ver cómo se comportaban mientras estaban vivas. El laboratorio de California tenía años de experiencia en uno de los métodos, mientras que en Massachusetts eran especialistas en el otro. Así que la idea era que cada laboratorio obtuviera las células independientemente, produjera datos con la técnica que mejor manejaban y los compartieran entre ellos para seguir adelante el proyecto conjunto.

Para poder estudiar las células, debían extraerlas de los pacientes mediante biopsias. Una biopsia es un pedazo de tejido tal cual como se extrae de una paciente, con diferentes tipos de células, una organización determinada, una estructura. Entonces, en ambos laboratorios, el primer paso fue conseguir células aisladas, lo que implicaba romper esa estructura para liberarlas.

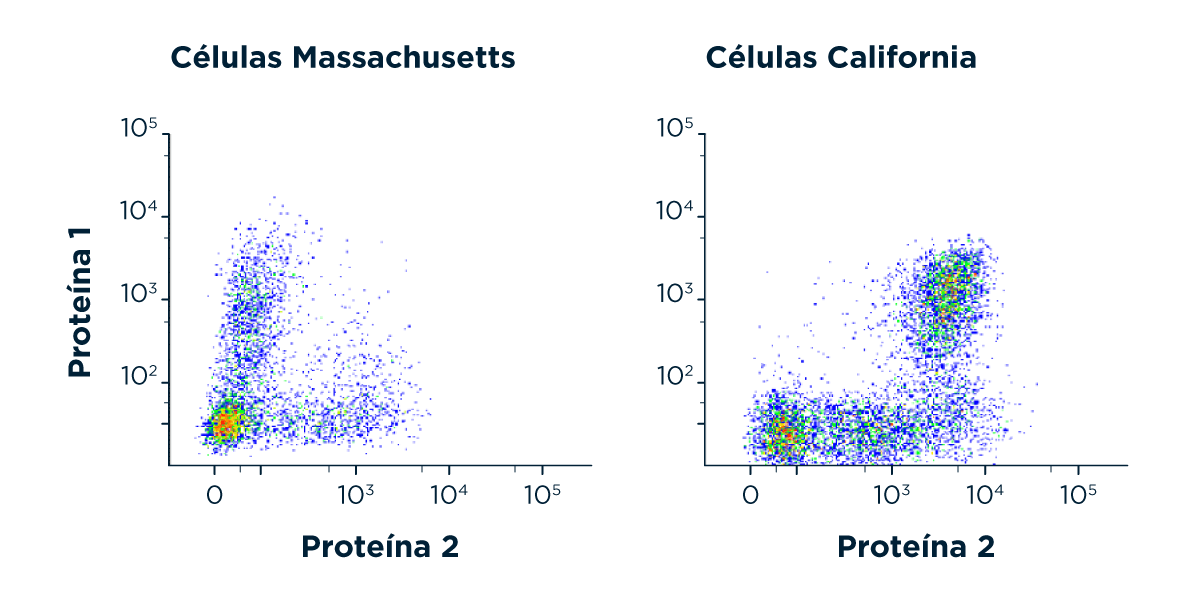

Estaban en eso, en el primer paso, cuando se dieron cuenta de que las células que se aislaban en California eran muy diferentes a las que se obtenían del otro lado del país. Todas las veces que procesaron las biopsias en el oeste, obtuvieron el mismo tipo de células, y cada vez que se aislaron en el este las células obtenidas eran iguales, pero la forma, el tamaño, las características de su superficie (lo que llamaríamos perfil celular) del oeste eran totalmente diferentes a las del este. De hecho, una de las diferencias más importantes, y que se evidenció con un ensayo de rutina, estaba en el tipo de proteínas que las células tenían en su superficie. Estas proteínas están involucradas en procesos de comunicación celular, migración, respuesta a estímulos externos, etc. Que el repertorio de proteínas no fuera igual en ambos laboratorios, entonces, era preocupante, porque podía afectar al comportamiento de las células en futuros experimentos.

En estos gráficos de perfil celular, cada punto es una célula. Cuanto más a la derecha o más arriba están, mayor cantidad de una determinada proteína presentan en su membrana (es decir, en la superficie). Se aprecia claramente que la diferencia era demasiado grande para hacerse los salames.

El hecho de que un resultado no pueda repetirse en otros laboratorios es normalmente fuente de ansiedad, pánico y crisis profesional entre quienes investigan. Y no es raro de escuchar: pasa más seguido de lo que les gustaría a los científicos, inversores, industrias farmacéuticas y a la sociedad en general. El sistema entero se basa en la reproducibilidad, es decir, en que un resultado se pueda volver a lograr independientemente de quién lo hace o dónde, si se siguen los mismos pasos. Es una de las pruebas más contundentes de que un descubrimiento es robusto, y no una casualidad o un fraude. Sin embargo, hoy en día, el monstruo de la falta de reproducibilidad acecha en todas las esquinas, en todos los laboratorios de todas las disciplinas. Por eso, a la hora de describir los descubrimientos de un grupo de investigación, es muy importante explicar al detalle cómo se hicieron los experimentos. No basta con comentar (por ejemplo) qué técnicas se usaron y declarar con qué animal o tipo de célula se trabaja, sino que también hay que consignar datos como dónde fueron adquiridos, de qué país provienen, de qué marca y procedencia son todas las drogas y reactivos que se usaron en el estudio, qué modificaciones genéticas se utilizan, etcétera, etcétera. Cuantos más detalles se dan, más información hay para que otros grupos de investigación puedan repetir el experimento en las mismas condiciones y chequear que el resultado sea igual, aportando así a su reproducibilidad y ahorrándose el tipo de problemitas que tantos dolores de cabeza le trajeron al Dr. Jekyll, o al menos detectándolos a tiempo.

Y ahora voy a probar en mi cuerpo este experimento que hice con insumos de procedencia dudosa.

Este nivel de detalle que las revistas piden para la publicación de manuscritos fue incrementando con el correr de los años, porque empezó a saltar una ficha que resultó bastante incómoda para la comunidad científica, y acá viene a cuento lo que ocurrió durante la colaboración entre los laboratorios de California y Massachusetts.

El proyecto era muy ambicioso y había bastante plata puesta en él (y eso significaba que podía ser un ladrillo importante en la pared del conocimiento). Así que decidieron parar los experimentos que seguían para determinar por qué las células obtenidas aquí y allá eran tan distintas, e intentar solucionarlo antes de mandarse a hacer los experimentos que realmente les interesaban. Porque, además, un problema sin solución, una pregunta sin respuesta, es la nafta de la máquina llamada ‘vocación científica’.

¿A qué podía deberse esta diferencia tan grande? Se descartó desde el principio la posibilidad de que las diferencias estuvieran en las biopsias, porque el diseño del experimento exigía un cierto nivel de similitud entre las personas de las que se podían extraer muestras, así como en la manera de obtenerlas. Imaginaron, entonces, una lista de posibles factores que podían diferir entre laboratorios:

– Los equipos que se utilizaban para el análisis.

– La calibración de dichos equipos.

– La manera de obtener la muestra.

– La procedencia de insumos y reactivos.

– La marca de estos insumos.

– La manera de procesar los tejidos para obtener células aisladas.

– Los métodos de caracterización de las células.

Ambos grupos hicieron un trabajo extra para chequear que se utilizaran instrumentos de las mismas marcas, volvieron a calibrar los equipos utilizando los mismos criterios, cambiaron los reactivos, medios de cultivo, insumos, para que fuesen todos iguales, e incluso, cuando todo esto falló, intercambiaron reactivos (no fuera cosa que, aunque eran de la misma marca, la fabricación de los mismos en el este y en el oeste fuera de todas formas diferente). Ninguna de estas medidas logró acercarlos a una explicación sobre lo que estaba pasando.

La pista que empezó a desarmar el ovillo de problemas, que ya estaba comenzando a hacerles perder tiempo, plata y ganas, apareció un año después, cuando decidieron procesar las muestras en California y mandarlas a analizar a Massachusetts y descubrieron que las células eran mucho más parecidas a las que siempre se obtenían en la costa oeste. Por lo tanto, concluyeron que la diferencia estaba en la preparación de las células. El siguiente paso fue obtener una muestra, dividirla en dos partes iguales, y hacer que en el mismo laboratorio, codo a codo, una persona de cada grupo procesara una mitad de muestra como usualmente lo hacía. Ahí descubrieron que, aunque los métodos parecían, y eran en teoría, exactamente iguales, había detalles (que creyeron en un principio insignificantes) que lo cambiaban todo: con exactamente los mismos reactivos, el ‘método California’ generaba ‘células California’, mientras que el ‘método Massachusetts’ generaba (a esta altura suena lógico, pero implicó muchos dolores de cabeza y dólares de bolsillo) ‘células Massachusetts’.

Para hacerla corta, luego de sentarse a repasar al detalle cada paso de los métodos usados para aislar y caracterizar las células, encontraron que el problema radicaba en la forma de agitar los tubos de ensayo. Si se los agitaba con amor se generaban células California, y cuando lo hacían con más vigor, células Massachusetts. La razón de semejante diferencia no está muy clara, pero los responsables de este estudio intentan explicarla a partir de una posible “fragilidad” de una de esas proteínas de superficie, llamada CD44, que aparentemente no se banca un sacudón y a la primera de cambio se suelta de la célula. La cuestión es que el asunto finalmente se resolvió y los métodos fueron unificados, pero el tiempo y el dinero que se perdió en el medio nos enseña una lección hermosa.

Perder el juego

¿Qué habría pasado si estos dos laboratorios no se hubiesen tomado el trabajo de pensar por qué las mediciones eran tan diferentes? ¿O si no hubiesen estado colaborando, sino que cada uno por su cuenta generaba sus propios resultados? A lo mejor cada laboratorio continuaba con sus experimentos sin saber que las diferencias entre las células se debían a la manera de procesar las biopsias. Quizás esas diferencias entre las células habrían impactado en su comportamiento frente a una droga, y no sería descabellado plantear que el grupo de California podría haber concluido que dicho compuesto mata a las células mientras que en Massachusetts habrían descubierto que la misma droga no las afecta. Lo más seguro es que cada laboratorio habría publicado sus resultados independientemente y habrían contribuido al océano de información contradictoria que existe en la actualidad.

Hay tantos casos similares a este que se está hablando de una verdadera crisis de reproducibilidad, la cual nos está haciendo perder tiempo (y plata) como humanidad. A la vez que estamos desarrollando herramientas más sensibles y conocimiento cada vez más específico, se corre el riesgo de perder la mirada integral de los problemas abordados, dando origen a este tipo de inconvenientes. Si un experimento no puede ser reproducido por otras personas, ¿vale? ¿Cuenta? En un caso como este, ¿a quiénes les creeríamos?¿A quienes dijeran que la droga mata a las células o a los que afirmaran lo contrario?

Todo esto, sumado al paradigma actual de ‘publicar o perecer’, que tiene que ver con aquella necesidad de publicar mucho en buenas revistas para poder obtener financiación, equipamiento o espacio de trabajo, genera un enorme cuerpo de información contradictoria. En principio, esto no sería un problema tan grave (es más: puede ser un buen empujón hacia nuevos experimentos y más descubrimientos interesantes) si existiera la costumbre de averiguar el motivo de la contradicción. Pero eso no es lo que suele suceder. No siempre se chequean las razones de esa contradicción, en parte porque no hay tiempo en la línea de producción de papers para tomarse el trabajo de pensar por qué allá no pueden reproducir los resultados que se obtienen acá: ‘problema de ellos, si total, yo ya publiqué mi paper’. ¿Y no puede ser una diferencia tan simple, insignificante, y desapercibida como la manera de agitar un tubo, una de las posibles razones por las que hay tanta información contradictoria?

¿Esto quiere decir que entonces todo es mentira y nada sirve para nada? De ninguna manera. La ciencia, y el método hipotético deductivo como metodología científica, siguen siendo hasta ahora los instrumentos más eficaces en la búsqueda de ‘La Verdad’, o de algo que al menos se le parezca lo suficiente; un sistema que nos permite acceder a la mejor descripción posible de la realidad. Los descubrimientos científicos se ponen a prueba constantemente dentro y fuera de los laboratorios: durante nuevos experimentos, en los desarrollos tecnológicos, en los tratamientos médicos. No olvidemos que, si los ladrillos no son sólidos, la pared se cae por su propio peso. Y, sin ir más lejos, fue gracias a la ciencia que se pudo llegar a una explicación y con ella a una solución de los problemas de reproducibilidad en este caso. Porque, aunque en la ciencia siempre hay ‘lugar a dudas’, también hay siempre un experimento o una observación que ayuda a despejarlas con evidencias y argumentos.

Las personas que investigan pasan una enorme cantidad de horas al día dentro de un laboratorio u otros espacios de investigación. Para alguna gente, publicar un trabajo original con un descubrimiento interesante y nuevo es el final del recorrido de un proyecto de años. Lo cierto es que es sólo el principio: cada respuesta genera más preguntas y nunca se sabe cuándo un desarrollo innovador puede convertirse en tecnología de punta para resolver problemas de la vida real. La ciencia no es una carrera cuya meta final es un descubrimiento; en realidad se parece más a una carrera de postas, sin fin, donde cada meta es siempre un nuevo punto de partida. Perder esto de vista es perder el juego.

Reportes registrados

Algunas dinámicas están empezando a aplicarse en ciertos ámbitos para tratar de solucionar el tema de la reproducibilidad. Existen revistas que admiten lo que se denomina ‘reportes registrados’, y que surgen como una alternativa para resolver problemas como el aquí mencionado. Se trata de publicaciones que tienen dos instancias de revisión por pares: primero se publican las hipótesis a testear y los métodos y protocolos que se planea seguir para los experimentos. Esto es revisado y criticado por otros profesionales, y queda pendiente el reporte de los resultados obtenidos con estos métodos, que luego también serán sometidos a revisión. Esto permite que se pongan a prueba los pasos a seguir antes de comenzar a invertir el tiempo y el dinero en los experimentos. Además, la aprobación del protocolo supone una ‘pre-aceptación’ del trabajo, es decir que los investigadores tienen un incentivo adicional para publicar los resultados provenientes de esos ensayos, sean cuales sean. Porque también está ese problema: muchas revistas prefieren no publicar lo que se llama ‘resultados negativos’, aquellos que demuestran la falta de efecto del factor en estudio. Esto implica toneladas de conclusiones del estilo ‘esto no le hace ni cosquillas a esta enfermedad’ escondidos en un placard y que, si se publicaran, también ahorrarían tiempo y dinero a la comunidad científica. En el mismo sentido, otra de las ventajas de los reportes registrados es que, si el proyecto y los métodos no son lo suficientemente buenos para ser pre-aprobados, el científico puede decidir recalcular a tiempo antes de poner manos a la obra en generar resultados inútiles o poco interesantes.

Desde el laboratorio, lo mejor que se puede hacer es estar en contacto permanente con personas con otras formaciones, como estadísticos, bioinformáticas, farmacéuticos, especialistas de bioterio, médicos, biólogas, epistemólogos e incluso filósofas, para que desde todas las disciplinas posibles se critique constructivamente y se busque fortalecer los proyectos antes de convertirlos en datos, resultados, conclusiones, y publicaciones con fuerza de verdad. Si apuntamos a que los resultados sean tomados por futuros investigadores, por Estados que diseñen políticas basadas en esas evidencias y por empresas que generen productos que impacten directamente en la vida de las personas, la responsabilidad de la comunidad científica es la de dialogar constantemente, intercambiar métodos y protocolos, generar verdaderas colaboraciones y producir conocimiento fidedigno para la construcción de esa pared. En suma, fabricar ladrillos de datos que no sólo sean sólidos entre sí, sino que también tengan sentido al entrelazarse con los resultados del resto del mundo. Porque ningún laboratorio es una isla, y un ladrillo no es una pared.